【Head-DETR系列(10)】Sparse DETR: efficient end-to-end object detection with learnable sparsity

DAM是通过聚合解码器中所有对象查询(object queries)对编码器输出令牌(tokens)的交叉注意力权重生成的。

论文:Sparse DETR: Efficient End-to-End Object Detection with Learnable Sparsity

地址:https

背景

DETR缓慢收敛性研究

Deformable DETR[43] 通过为查询元素生成参考点引入了可变形注意力模块,每个参考点仅集中在整个特征图上的少数几个位置。另一种方法是在解码器中为目标查询添加更多先验信息。

Conditional-DETR[20] 将目标查询中的上下文特征和位置特征解耦,并按空间位置生成位置特征。

DAB-DETR[19] 进一步将宽度和高度信息引入位置特征。Anchor-DETR[31] 也将锚点编码为具有多种模式的目标查询,并进一步设计了行列解耦注意力机制以降低内存成本。

DINO[41] 的最新工作借鉴了现有的新技术,并通过扩大模型和数据集的规模进一步发挥了 DETR 的潜力。

DETR模型的规模和计算成本the scale and computer cost

the scale and computation cost

DETR 的另一个问题是模型的规模和计算成本。目前的研究通过设计更高效的 DETR 架构来解决这个问题。

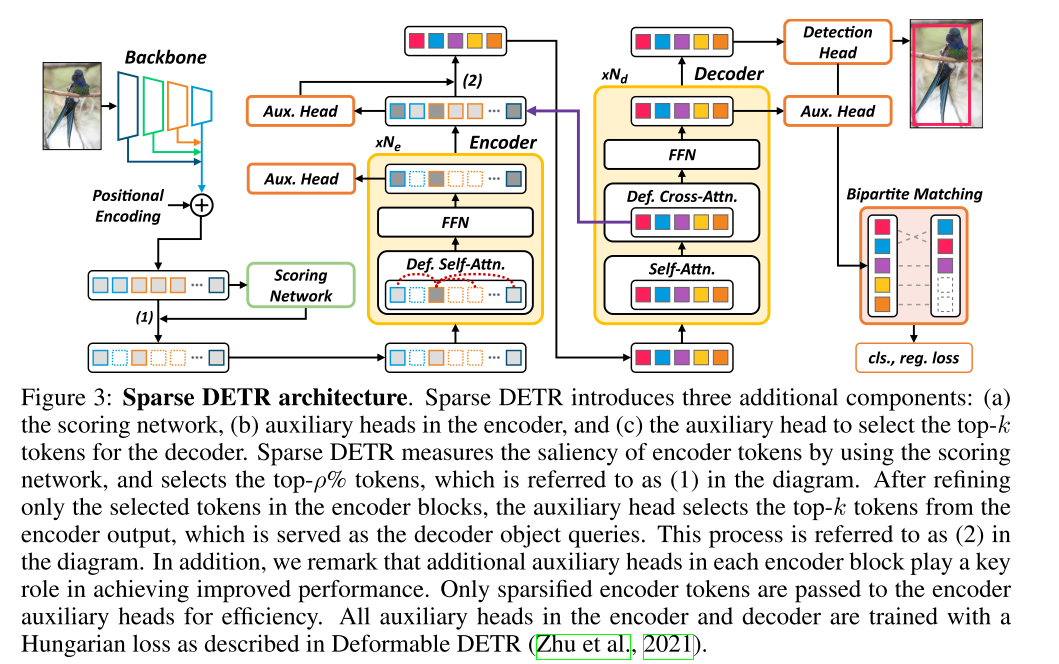

Sparse DETR[24] 通过稀疏编码器 token 来降低计算成本。

Efficient DETR[36] 则引入了 RPN 来生成对象查询,并消除了 DETR 中的级联解码器层。

PnP DETR[30] 通过轮询和池化采样模块缩短了采样特征的长度。

paper: Sparse DETR

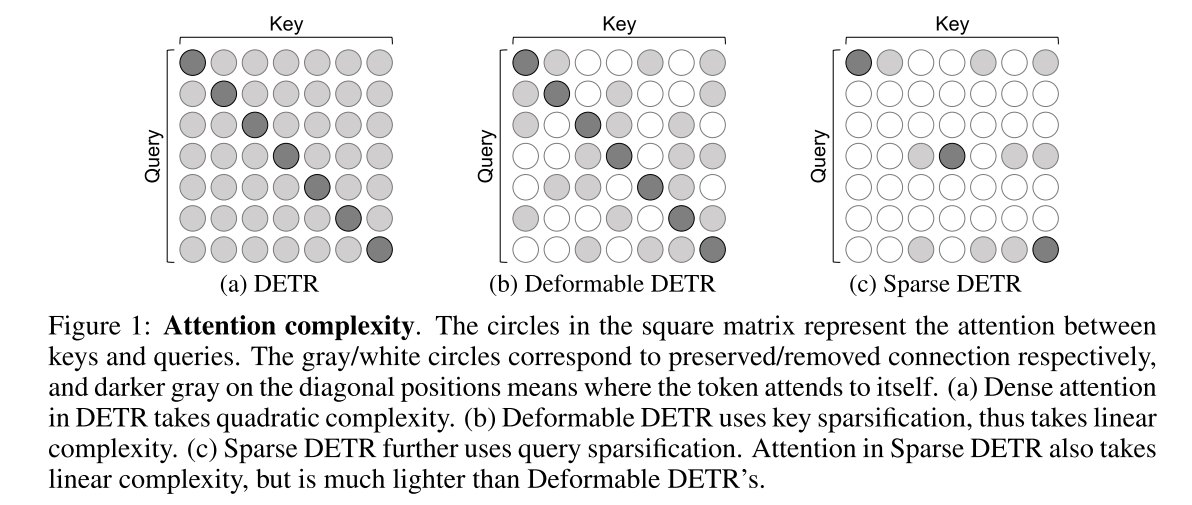

DETR 是首个采用 Transformer 编码器-解码器架构的端到端目标检测器,在高分辨率特征图上展现出颇具竞争力的性能,但计算效率较低。

1、因为Transformer的结构限制,DETR不能采用特征金字塔增强小目标的性能,多尺度的特征图的self-attention 操作会占用大量的内存和算力(如图1a)。

2、Deformable DETR 通过将密集注意力机制替换为可变形注意力机制,提升了 DETR 的效率,实现了 10 倍的收敛速度和性能提升。其主要是减少attention中key的数量,其主要是减少attention中key的数量

3、Deformable DETR 利用多尺度特征提升了性能,然而,与 DETR 相比,编码器 token 的数量增加了 20 倍,并且编码器注意力机制的计算成本仍然是瓶颈。尽管Deformable DETR提出的 sparse key的技术能够减少计算量使得DETR类的模型引入多尺度特征图提高了检测器的性能,但是多尺度特征图依然带来了更多的query相比于原始的单层DETR,导致推理速度过慢。

作者认为自然图像包含了大量的背景区域,这些背景token和前景token被同等对待产生了大量的冗余计算。之前的两阶段算法已经证明仅用前景区域可以实现较好的检测性能。这表明,在检测任务中存在可以减少的相当大的区域冗余,寻求设计一种有效的检测器来关注显著区域是一个必要和自然的方向。

在初步实验中,我们观察到即使仅更新部分编码器 token,检测性能也几乎不会下降(performance hardly deteriorates)。

受此观察的启发,我们提出了Sparse DETR,它选择性地仅更新解码器预期会引用的 token,从而帮助模型有效地检测目标。此外,我们还表明,在编码器中对选定的 token 应用辅助检测损失可以提高性能,同时最大限度地降低计算开销。我们验证了稀疏 DETR 在 COCO 数据集上即使仅使用 10% 的编码器 token,其性能也优于可变形 DETR。尽管只有编码器 token 进行了稀疏化,但与可变形 DETR 相比,总计算成本降低了 38%,每秒帧数 (FPS) 提高了 42%。代码可访问 https://github.com/kakaobrain/sparse-detr。

1、introduce

在我们的初步实验中,我们观察到以下情况:

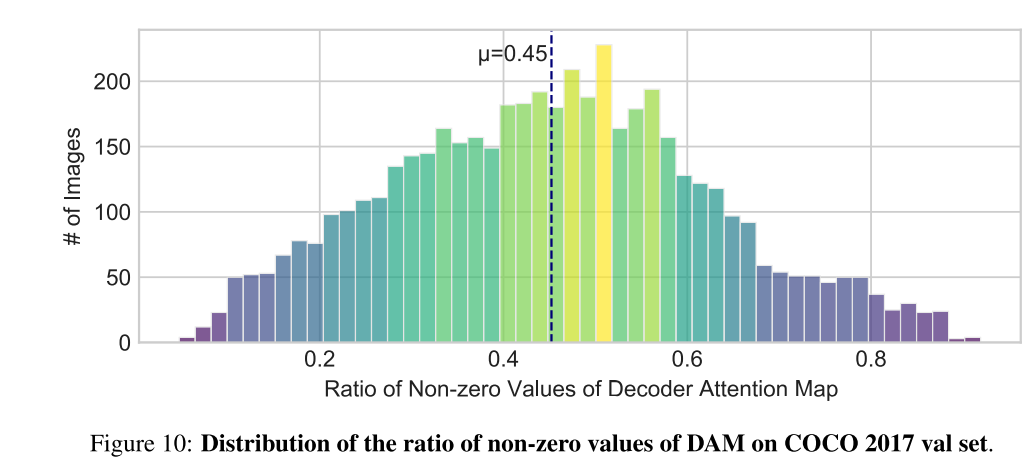

- (a)在 COCO 验证数据集上对完全收敛的Deformable DETR 模型进行推理时,解码器引用的编码器标记tokens仅占总数的 45% 左右;

- (b)重新训练新的检测器,同时仅从另一个经过完全训练的检测器中更新解码器所偏好的编码器标记tokens,性能几乎不会受到损失(AP 值下降 0.1)。详情请参阅附录 A.9。

受此观察的启发,我们提出了一个可学习的解码器交叉注意力图预测器来稀疏化编码器标记tokens。在现有方法(Carion 等人,2020;Zhu 等人,2021)中,编码器将所有tokens(即骨干特征与相应的位置嵌入的组合)不加区分地作为输入。同时,我们的方法区分了解码器后续将要引用的编码器标记tokens,并在自注意力机制中仅考虑这些标记。因此,这可以显著减少参与计算的编码器标记数量,并降低总计算成本。我们进一步提出了针对特定编码器标记tokens的编码器辅助损失,以在最小化计算开销的同时提升检测性能。所提出的辅助损失不仅提升了性能,还允许训练更多数量的编码器层。

A.9 THE PRELIMINARY EXPERIMENTS: WHY PURSUE A SPARSE ENCODER?

使用经过 Deformable-DETR 训练的模型,我们分析了encoder output tokens引用的decoder’s object query的数量。与附录 A.2 中描述的使用双线性插值生成用于伪标签训练的 DAM 不同,在本分析中,我们不使用双线性插值来计算ecoder object query直接引用的how many encoder tokens。为了分析 DAM 的非零值,我们使用了基于 ResNet-50 主干网络、采用 Top-k 采样策略(Yao et al., 2021)和边界框细化(Zhu et al., 2021)训练的 Deforamble DETR 模型。图 10 展示了 COCO val2017 数据集上 DAM 非零值比例的分布。如图 10 所示,平均而言,只有 45% 的编码器标记被目标查询引用。

这一观察结果自然引出了一个问题:即使我们一开始就只关注解码器可能偏好的编码器标记,我们还能保持检测性能吗?

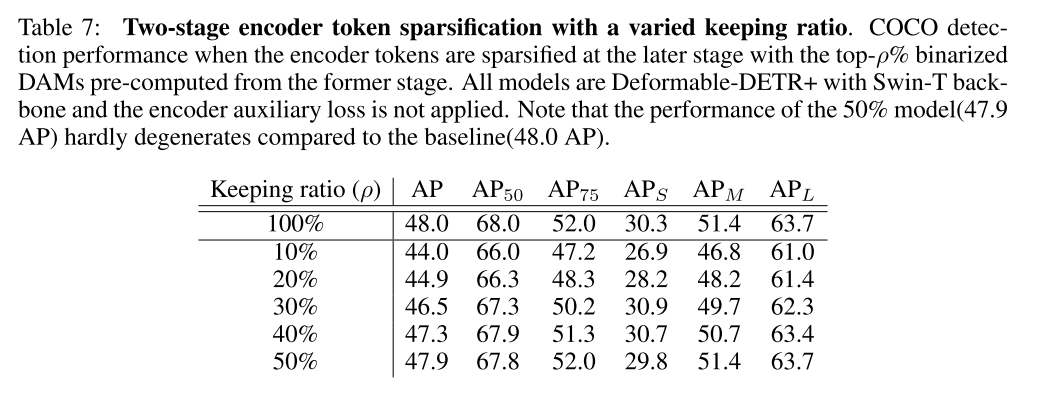

为此,我们进行了如下两阶段学习:

两阶段实验设计:

- 第一阶段:用完整模型生成DAM,统计被引用token的分布。

- 第二阶段:仅更新DAM中保留的Top-ρ% token(其余标记冻结),重新训练模型。

当ρ接近45%时,性能与基线相当,验证了稀疏化的潜力。

(i) 我们首先通过将整个训练数据的 DAM 输入到经过充分训练的 Deformable-DETR 模型中来获取它们。

(ii) 然后,我们从头开始重新训练另一个模型,通过仅更新由二值化 DAM 确定的标记子集来保留元素的前 ρ%(有关更多详细信息,请参阅第 3.3 节)。表 7 显示了不同保留率 ρ 在 COCO 检测上的性能。我们发现,当保留率提高到接近 45%(即先前在验证数据集上计算的 DAM 中非零值的百分比)时,两阶段模型几乎赶上了基线(ρ = 100%)。

需要注意的是,我们的主要算法与此初步实验在某些方面有所不同:(a) DAM 是从联合学习解码器获得的,而不是从单独训练的解码器获得的;(b) 二值化的 DAM 被用作评分网络的预测目标,而不是直接用作稀疏化掩码。

2 RELATED WORK

视觉 Transformer 中的高效计算。众所周知,Transformer 中的注意力机制计算时间复杂度和内存复杂度都很高。由于视觉 Transformer 需要消化更大的 token 集作为输入,因此大量研究提出了轻量级的注意力机制。这些研究大多揭示了单尺度注意力模块的复杂性,这阻碍了其直接扩展到目标检测中通常需要的多尺度特征。

实现更轻量级 Transformer 注意力机制的一种有前景的方法是输入相关的 token 稀疏化。与我们的工作类似,DynamicViT (Rao 等人,2021) 和 IA-RED2 (Pan 等人,2021) 都提出了联合学习的 token 选择器,用于生成要叠加在输入 token 上的稀疏模式。这些方法主要侧重于对在分类任务上评估的骨干网络进行稀疏化,而我们的兴趣则在于端到端目标检测器的稀疏编码器。

另一方面,有一系列研究与我们秉持相同的理念,致力于基于 DETR 框架的稀疏 Transformer。

- Deformable DETR (Zhu et al., 2021) 通过仅从整个键集的一小部分采样可学习的二维偏移量来进行稀疏注意力计算,从而能够以合理的计算成本使用多尺度特征图。它可以被视为一种键稀疏化方法,但用于密集查询,而我们的方法则进一步缩减查询集以追求更高的稀疏度。

- PnP-DETR (Wang et al., 2021) 通过引入轮询和拉取 (PnP) 模块来采样前景 token 并将背景 token 压缩为更小的集合,从而缩短了 Transformer 编码器的 token 长度。然而,他们的方法无法简单地与Deformable DETR 集成,因为他们的稀疏化破坏了可变形注意力中假设的 token 集的二维空间结构。

- 相反,Sparse DETR 保留了集合的二维样本空间,并且可以与可变形注意力机制无缝结合,从而有助于处理多尺度特征。

因此,我们的方法既受益于Deformable 键采样,也受益于所提出的查询稀疏化(eformable key sampling and the proposed query sparsification)。最重要的是,我们为 token 选择网络提出了明确的目标,而上述研究并没有明确的目标来表明其对良好选择策略的信念,而仅仅依赖于最终的检测目标。

辅助损失。辅助损失 (Lee et al., 2015; Szegedy et al., 2015) 被广泛用于向深度网络的早期层传递梯度。DETR 变体在每个解码器层的末尾使用辅助匈牙利匹配目标函数,并附加 FFN 头,以便每个解码器层能够直接学习从解码器的输出中检测出正确数量的对象。与解码器的对象查询(数量相对较小,例如 300)不同,在使用多尺度特征时,编码器的标记数量要大得多。因此,将逐层辅助损失扩展到多尺度编码器会通过向附加的 FFN 头输入过多的标记来增加训练时间成本。在稀疏 DETR 中,由于编码器中已经引入了稀疏性,我们可以立即节省这部分成本,同时在更广泛的中间层中享受辅助梯度。

3 APPROACH

在本节中,我们介绍主要贡献:(a) 为编码器构建一种基于显著性的广义标记稀疏化方案;(b) 提出该方案实际可行且有效的显著性准则;以及 © 利用编码器辅助损失和 Top-k 解码器查询选择来提升性能。在介绍细节之前,我们先回顾一下 DETR (Carion 等人,2020) 和可变形 DETR (Zhu 等人,2021) 的关键组件。

3.2 ENCODER TOKEN SPARSIFICATION

对encoder中的每层特征图的每个token预测显著性得分,根据得分大小选出topk token。然后在encoder中只对topk个token计算self-attention,其他token保持不变。

根据用户提供的图片内容(关于编码器令牌稀疏化方案的英文文本),以下是分步骤的解析,帮助理解其核心思想和技术细节:

1. 核心目标

问题:传统Transformer编码器对所有令牌(tokens)进行全局计算,导致高计算成本。

解决方案:提出选择性令牌稀疏化(Token Sparsification),仅对少数重要令牌进行细化和更新,其余令牌保持原值传递,从而减少计算量。

2. 关键步骤解析

(1) 令牌显著性评分

- 评分网络(Scoring Network)

定义一个函数 ( g : R d → R g: \mathbb{R}^d \rightarrow \mathbb{R} g:Rd→R ),对每个令牌 ( x feat \mathbf{x}_{\text{feat}} xfeat ) 计算显著性分数(saliency score),分数越高表示越重要。- 输入:令牌特征(维度 ( d ))。

- 输出:标量分数(如基于注意力权重或任务相关性的度量)。

(2) 选择显著区域(Salient Regions)

- 给定保留比例 ( ρ % \rho\% ρ% ),选择分数最高的前 ( ρ % \rho\% ρ% ) 令牌,构成显著区域 ( Ω s ρ \Omega_s^\rho Ωsρ )。

- 例如:( ρ = 30 % \rho=30\% ρ=30% ) 时,仅更新30%的令牌,其余70%直接传递。

- 公式:( S = ∣ Ω s ρ ∣ = ρ ⋅ ∣ Ω q ∣ ≪ N S = |\Omega_s^\rho| = \rho \cdot |\Omega_q| \ll N S=∣Ωsρ∣=ρ⋅∣Ωq∣≪N )(( N ) 为总令牌数)。

(3) 分层更新机制

对第 ( i ) 层编码器的更新规则(分两种情况):

-

非显著令牌(( j ∉ Ω s ρ j \notin \Omega_s^\rho j∈/Ωsρ ))

- 直接传递:( x i j = x i − 1 j \mathbf{x}_i^j = \mathbf{x}_{i-1}^j xij=xi−1j )(不计算自注意力或FFN)。

- 作用:保留原始信息,供后续层或其他令牌参考(如作为Key)。

-

显著令牌(( j ∈ Ω s ρ j \in \Omega_s^\rho j∈Ωsρ ))

- 通过可变形注意力(DefAttn)和FFN细化:

x i j = LN ( FFN ( z i j ) + z i j ) , 其中 z i j = LN ( DefAttn ( x i − 1 j , x i − 1 ) + x i − 1 j ) \mathbf{x}_i^j = \text{LN}\left( \text{FFN}(\mathbf{z}_i^j) + \mathbf{z}_i^j \right), \quad \text{其中 } \mathbf{z}_i^j = \text{LN}\left( \text{DefAttn}(\mathbf{x}_{i-1}^j, \mathbf{x}_{i-1}) + \mathbf{x}_{i-1}^j \right) xij=LN(FFN(zij)+zij),其中 zij=LN(DefAttn(xi−1j,xi−1)+xi−1j) - 关键点:

- 可变形注意力(DefAttn)仅作用于显著令牌,但可参考所有令牌(包括非显著令牌)作为Key-Value。

- 层归一化(LN)和残差连接(Residual)保持训练稳定性。

- 通过可变形注意力(DefAttn)和FFN细化:

3. 设计优势

- 计算效率:仅更新部分令牌,大幅减少FLOPs(尤其是DefAttn和FFN的计算)。

- 信息保留:非显著令牌虽不更新,但仍作为Key参与显著令牌的注意力计算,避免信息丢失。

- 通用性:与注意力机制无关(如DefAttn、标准Attention均可适用)。

4. 与DAM的关联(结合用户前文提问)

- DAM的作用:在初步实验中,DAM用于统计解码器引用的编码器令牌分布,验证了编码器令牌的天然稀疏性(仅45%被引用)。

- 本文方案的改进:

- 不再依赖DAM的统计结果,而是通过评分网络动态预测显著令牌(端到端学习)。

- 评分网络的目标是模仿DAM的稀疏模式,但更灵活(如适应不同 ( \rho ) 或任务需求)。

5. 总结

- 核心思想:通过显著性评分动态选择重要令牌,仅细化这部分令牌,同时保留其他令牌的原始信息。

- 技术实现:评分网络 + 分层条件更新 + 可变形注意力。

- 意义:在计算效率和模型性能之间取得平衡,适用于计算资源受限的场景(如边缘设备)。

3.3 FINDING SALIENT ENCODER TOKENS

如何得到每个token的显著性得分作者进行了探讨,

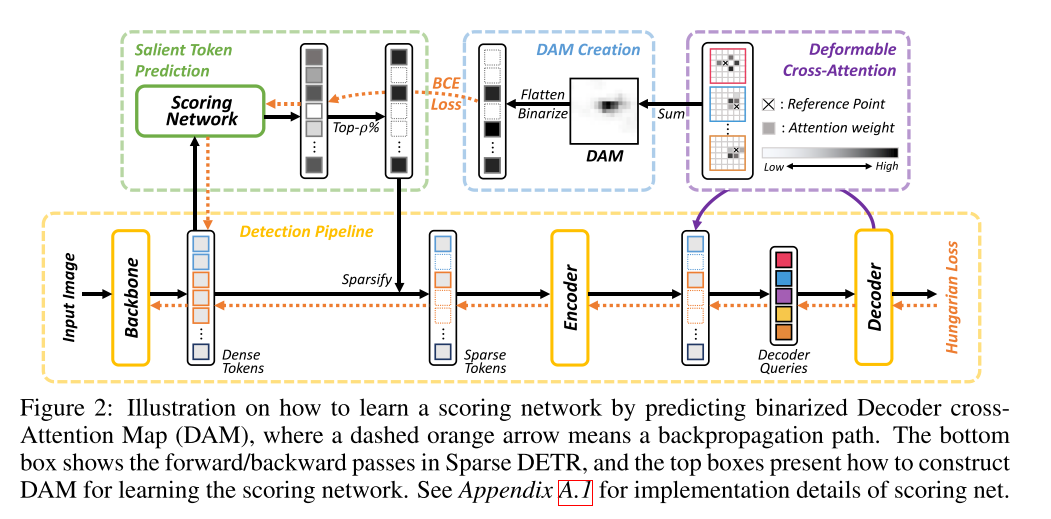

- objectless score:通过在feature map上加入额外的检测头和Hungarian loss ,根据检测头的分类得分作为特征图中的每个token的显著性得分,这种方法简单有效但是没有考虑到encoder token和decoder的关联。

- decoder attention map :通过一种显式的方法选择和decoder高度相关的encoder token子集。

在decoder cross-attention map(DAM)由object queries 和 feature map计算相似度得到,其反应了feature map中每个token和decoder的关联程度。作者通过对每个decoder layer的attention map求和得到最终的DAM。对于deformable attention中每个encoder token的DAM作者是通过decoder中object query的attention weights求和得到的。对DAM的topk进行二值化作为feature map tokens显著性得分的标签,训练一个得分网络。通过BCEloss进行优化。如图2所示。

**解码器交叉注意力图(Decoder Cross-Attention Map, DAM)**及其在编码器令牌稀疏化中作用的逐步解析:

1. DAM的核心定义

DAM是什么?

DAM是通过聚合解码器中所有对象查询(object queries)对编码器输出令牌(tokens)的交叉注意力权重生成的空间显著性热图。

- 生成方式:

- 密集注意力:直接对所有解码器层的注意力图求和。

- 可变形注意力:累加指向同一编码器令牌的所有解码器查询的注意力权重(需考虑偏移后的位置)。

- 物理意义:

DAM的每个位置值表示对应编码器令牌被解码器引用的频率或强度,反映其对目标检测任务的重要性。

2. DAM的用途:指导编码器令牌稀疏化

(1) 显著性筛选逻辑

- 假设:解码器在训练过程中会逐渐聚焦于少数关键编码器令牌(如物体区域对应的令牌),其余令牌贡献微弱。

- DAM的作用:

通过统计DAM中高权重区域,筛选出解码器最关注的Top-ρ%编码器令牌(即显著令牌),其余令牌可被稀疏化(不更新或轻量化处理)。

(2) 二值化DAM(Binarized DAM)

- 操作:

对DAM按权重排序,仅保留Top-ρ%的令牌位置为1,其余置0。- 公式化:

DAM i bin = { 1 if DAM i ∈ Top-ρ% of DAM 0 otherwise \text{DAM}^{\text{bin}}_i = \begin{cases} 1 & \text{if } \text{DAM}_i \in \text{Top-ρ\% of DAM} \\ 0 & \text{otherwise} \end{cases} DAMibin={10if DAMi∈Top-ρ% of DAMotherwise

- 公式化:

- 目的:

将连续注意力权重转化为二值掩码,明确区分显著与非显著令牌,简化评分网络的学习目标。

3. 评分网络的训练与作用

(1) 网络结构

- 输入:编码器令牌特征 ( x feat \mathbf{x}_{\text{feat}} xfeat )(维度 ( d ))。

- 输出:标量分数,预测该令牌属于Top-ρ%显著令牌的概率。

- 架构:4层全连接网络(或其他轻量设计)。

(2) 损失函数

使用二元交叉熵(BCE)损失,迫使评分网络模仿二值化DAM的分布:

L dam = − 1 N ∑ i = 1 N [ DAM i bin ⋅ log g ( x feat ) i + ( 1 − DAM i bin ) ⋅ log ( 1 − g ( x feat ) i ) ] \mathcal{L}_{\text{dam}} = -\frac{1}{N} \sum_{i=1}^{N} \left[ \text{DAM}^{\text{bin}}_i \cdot \log g(\mathbf{x}_{\text{feat}})_i + (1-\text{DAM}^{\text{bin}}_i) \cdot \log (1-g(\mathbf{x}_{\text{feat}})_i) \right] Ldam=−N1i=1∑N[DAMibin⋅logg(xfeat)i+(1−DAMibin)⋅log(1−g(xfeat)i)]

- 关键点:

评分网络学习的是相对重要性排序(即是否属于Top-ρ%),而非精确预测注意力权重的绝对值。

(3) 在线稀疏化应用

训练完成后,评分网络可动态预测输入图像的显著令牌:

- 推理阶段:对每个令牌计算 ( g ( x feat ) i g(\mathbf{x}_{\text{feat}})_i g(xfeat)i ),选择分数最高的ρ%令牌进行细化(如更新特征),其余令牌直接传递或丢弃。

- 优势:

避免依赖预计算的DAM,适应不同输入场景的显著性分布变化。

4. 与可变形注意力的协同

- 可变形注意力的角色:

在生成DAM时,可变形注意力通过偏移机制灵活捕捉稀疏但重要的区域(如小物体),使DAM更精准。 - 评分网络的补充:

可变形注意力提供DAM的初始稀疏性先验,而评分网络通过端到端训练进一步优化显著性预测的泛化性。

5. 总结:DAM与评分网络的工作流程

- 训练阶段:

- 用完整模型生成DAM → 二值化DAM → 训练评分网络模仿二值化分布。

- 推理阶段:

- 评分网络预测显著令牌 → 仅细化这些令牌 → 减少编码器计算量。

关键理解要点

- DAM的本质:解码器注意力行为的统计摘要,揭示编码器令牌的任务相关性。

- 稀疏化逻辑:通过DAM的显著性筛选,保留关键令牌,剪枝冗余计算。

- 评分网络的意义:将DAM的静态统计转化为动态预测,实现自适应稀疏化。

这种设计在目标检测等任务中,能在保持性能的同时显著提升计算效率(如减少50%以上的编码器计算量)。

3.4 ADDITIONAL COMPONENTS

Encoder auxiliary loss

在其他的DETR-like model中,由于encoder中多层feature map包含的token数量过多,引入额外的检测头会带来巨大的计算消耗。但是采用Sparse query方法只有少量的queries被decoder更新,因此仅对这部分少量的token引入额外的辅助检测头和Hungarian loss可以帮助encoder区分有困惑的特征并且加速模型的收敛。

Top-k decoder queries

1. 背景与问题

-

传统方法(DETR/Deformable DETR):

解码器的输入(decoder queries)是固定的可学习参数(learnable object queries)或通过编码器后的参考点预测头生成。- 局限性:

- 可学习查询与图像内容无关,可能引入冗余计算。

- 两阶段方案(如生成提案再精修)计算成本高。

- 局限性:

-

改进目标:

让解码器查询动态关联图像内容,提升效率与性能。

2. Efficient DETR的解决方案:Top-k Decoder Queries

(1) 核心思想

将编码器输出的部分特征(top-k个最可能包含目标的令牌)直接作为解码器查询,类似RoI Pooling的“区域聚焦”思想。

- 关键步骤:

- 计算目标性分数(Objectness Score):

通过一个辅助检测头(auxiliary detection head)对每个编码器输出 ( x enc x_{\text{enc}} xenc ) 预测其包含目标的概率(二分类:是/否目标)。 - 筛选Top-k令牌:

选择目标性分数最高的前 ( k ) 个编码器输出,作为解码器的输入查询(decoder queries)。

- 计算目标性分数(Objectness Score):

(2) 技术类比

- 与RoI Pooling的相似性:

RoI Pooling从区域提案(Region Proposals)中提取特征,而Top-k Decoder Queries从编码器输出中筛选“目标提案”。 - 与令牌稀疏化的关联:

目标性分数筛选(Top-k)与用户之前提到的编码器令牌稀疏化(Token Sparsification)逻辑一致,均基于显著性(目标性)过滤冗余信息。

(3) 优势

- 内容感知:解码器查询直接关联图像中的潜在目标区域,比固定查询更高效。

- 端到端优化:辅助检测头与主模型联合训练,无需额外提案生成步骤。

- 性能提升:文中提到该方法优于可学习查询和两阶段方案,因此被纳入最终架构。

3. 与DAM(Decoder Attention Map)的关联

- 逻辑一致性:

- DAM通过解码器注意力统计编码器令牌的重要性,而Top-k方法通过目标性分数直接预测重要性。

- 两者均用于筛选关键编码器输出,但DAM是后验统计,Top-k是前置预测。

- 互补性:

若将DAM的统计结果作为目标性分数的监督信号,可进一步提升Top-k筛选的准确性(文中未明确提及,但技术可行)。

4. 总结:如何理解Top-k Decoder Queries?

- 是什么:

一种动态选择解码器输入的方法,通过目标性分数从编码器输出中筛选最可能包含目标的Top-k个令牌。 - 为什么有效:

- 减少冗余查询,聚焦关键区域。

- 实现编码器-解码器的内容感知交互。

- 技术地位:

- 是DETR系列模型从固定查询到内容感知查询的重要改进。

- 与令牌稀疏化、RoI Pooling等技术共享“显著性筛选”的核心思想。

附:技术对比表

| 方法 | 解码器查询来源 | 优点 | 缺点 |

|---|---|---|---|

| DETR | 固定可学习参数 | 简单稳定 | 与图像内容无关 |

| Deformable DETR | 参考点预测头生成 | 部分内容感知 | 依赖额外预测头 |

| Efficient DETR | 编码器输出的Top-k目标性令牌 | 完全内容感知,计算高效 | 需辅助检测头 |

如需进一步探讨目标性分数的具体实现或与其他模块的协作细节,可继续深入。

网络结构

A附录

Deformable DETR’s Deformable Attention Map(DAM)

DAM(在可变形注意力机制中的具体名称需结合原文确认,可能是Deformable Attention Map或类似术语)是可变形注意力(Deformable Attention)中的一种辅助性积累机制,用于动态捕捉和整合注意力偏移的权重信息。以下是其核心要点:

DAM的定义与作用

-

基本原理

DAM通过双线性插值(Bilinear Interpolation)对注意力偏移的权重进行空间上的加权积累。与可变形注意力直接计算特征值(如公式中的 ( ∑ A ⋅ G ( x , r + p ) ⋅ v ( x ) \sum A \cdot G(x, r+p) \cdot v(x) ∑A⋅G(x,r+p)⋅v(x) ))不同,DAM仅积累权重与插值核的乘积(即 ( ∑ A ⋅ G ( x , r + p ) \sum A \cdot G(x, r+p) ∑A⋅G(x,r+p) )),不涉及特征值 ( v ( x ) v(x) v(x) )。 -

数学表达

- 对于解码器的每个对象查询(object query)( q ),给定其注意力偏移 ( p )、权重 ( A ) 和参考点 ( r ),DAM在位置 ( x ) 的积累值为:

DAM ( x ) = ∑ ( p , A , r ) A ⋅ G ( x , r + p ) \text{DAM}(x) = \sum_{(p,A,r)} A \cdot G(x, r+p) DAM(x)=(p,A,r)∑A⋅G(x,r+p) - 其中 ( G ( ⋅ , ⋅ ) G(\cdot,\cdot) G(⋅,⋅) ) 是双线性插值核,用于处理分数位置(fractional positions)的平滑插值。

- 对于解码器的每个对象查询(object query)( q ),给定其注意力偏移 ( p )、权重 ( A ) 和参考点 ( r ),DAM在位置 ( x ) 的积累值为:

-

与可变形注意力的关联

- DAM和可变形注意力共享相同的偏移计算逻辑(如 ( r+p )),但DAM仅关注权重的空间分布,而非最终的特征聚合。

- 可变形注意力通过 ( ∑ A ⋅ G ⋅ v ( x ) \sum A \cdot G \cdot v(x) ∑A⋅G⋅v(x) ) 输出特征,而DAM通过 ( ∑ A ⋅ G \sum A \cdot G ∑A⋅G ) 输出一个权重分布图,可能用于后续分析或调整注意力的聚焦区域。

DAM的用途

由于原文未明确说明DAM的具体应用场景,其可能用途包括:

- 可视化注意力区域:通过DAM的积累值,直观显示哪些空间位置被注意力机制频繁关注。

- 动态调整权重:作为中间结果辅助模型优化,例如抑制冗余注意力或增强关键区域的权重。

- 多任务学习:为其他任务(如目标检测的分割头)提供空间权重先验。

DAM是可变形注意力中用于量化注意力权重空间分布的机制,通过双线性插值积累偏移权重,反映了模型对输入特征不同区域的关注强度。其设计延续了可变形注意力的灵活性,但剥离了特征值的影响,专注于权重本身的统计分析。具体功能需结合模型整体架构进一步确认。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)