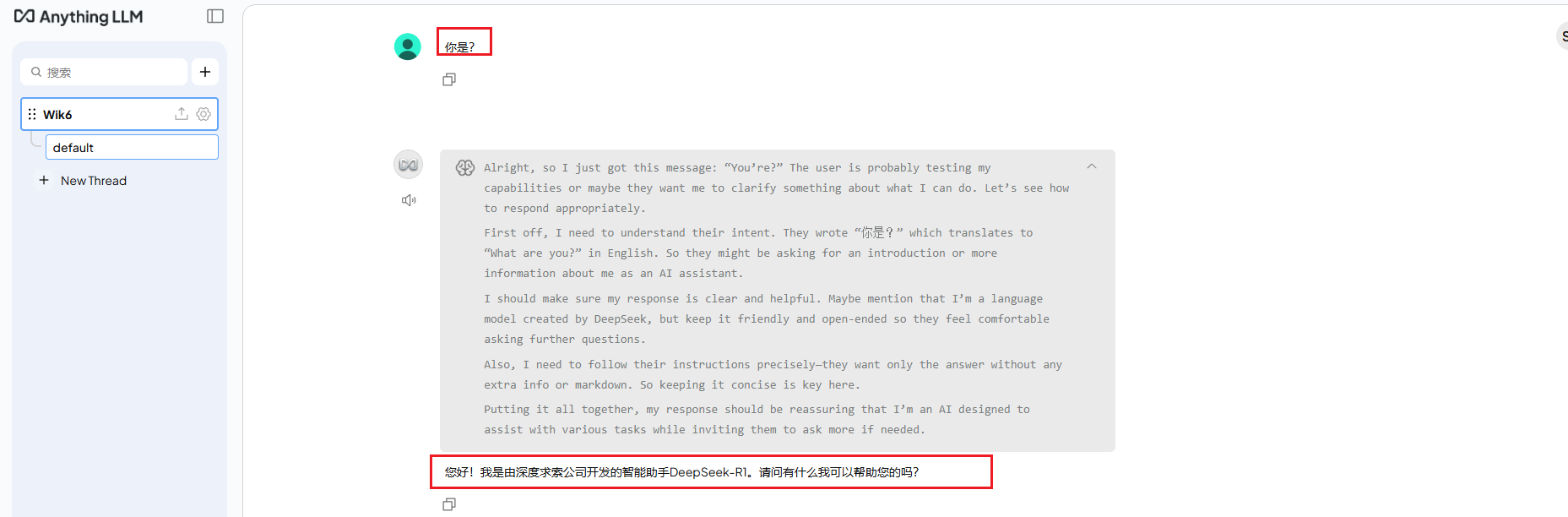

Linux安装AnythingLLM

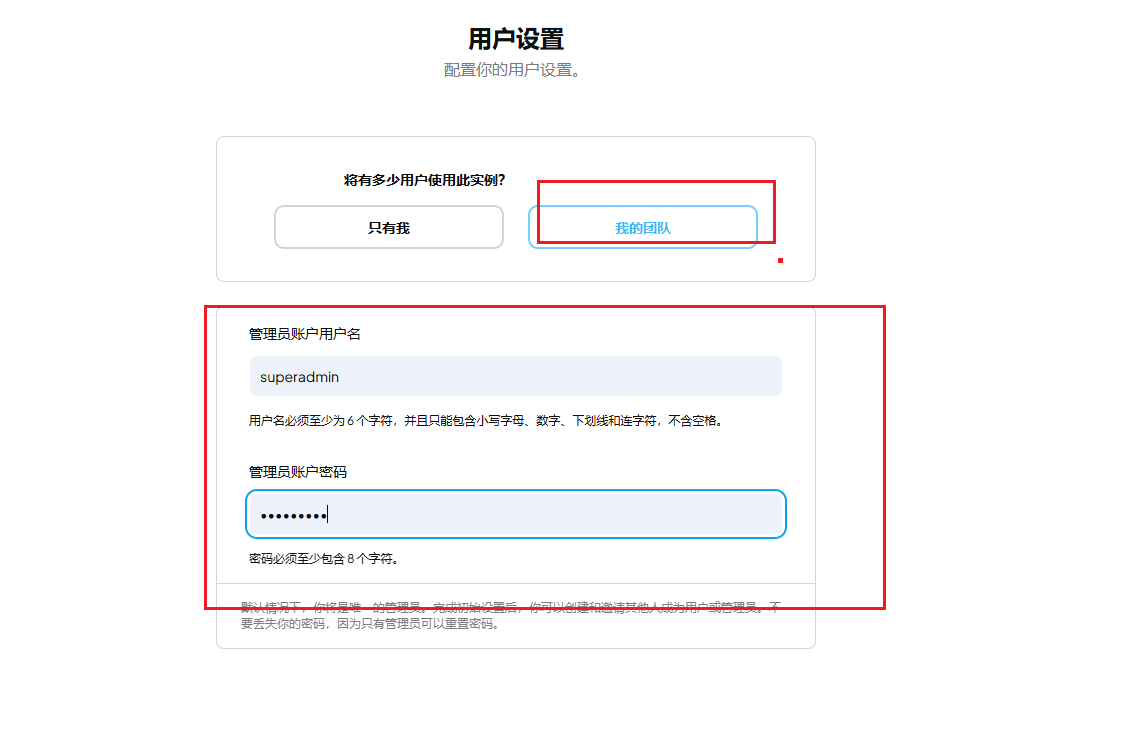

官网首页直接提供的Desktop脚本安装,只能够个人使用,无法多人使用。方式进行安装可以满足多人同时使用。我这里的模型是 本地。

·

AnythingLLM 与 RAGFlow 的区别分析

核心定位

- AnythingLLM:全栈私有化方案,强调数据100%本地化,注重企业级权限管理,通过多用户模式和工作区隔离,适合对数据隐私要求极高的场景(如法律案例库、制造业工艺文档管理等)。

- RAGFlow:企业级复杂文档处理专家,旨在通过深度文档理解技术,解决现有RAG技术在数据处理和生成答案方面的挑战,更适合处理法律合同审查、医疗报告分析等复杂文档场景。

文档处理能力

- AnythingLLM:支持200多种文档格式,可处理PDF、TXT、DOCX等常见文档,能提取文本信息并保存到向量数据库。

- RAGFlow:侧重于复杂格式文档处理(如扫描件、表格、影印件等),具备深度文档理解能力,可识别文档布局、表格单元格等细节。

检索精度

- AnythingLLM:采用常规向量检索方式。

- RAGFlow:通过多路召回+LLM重排序优化,能实现高精度检索,在处理复杂文档时,更准确地召回相关信息。

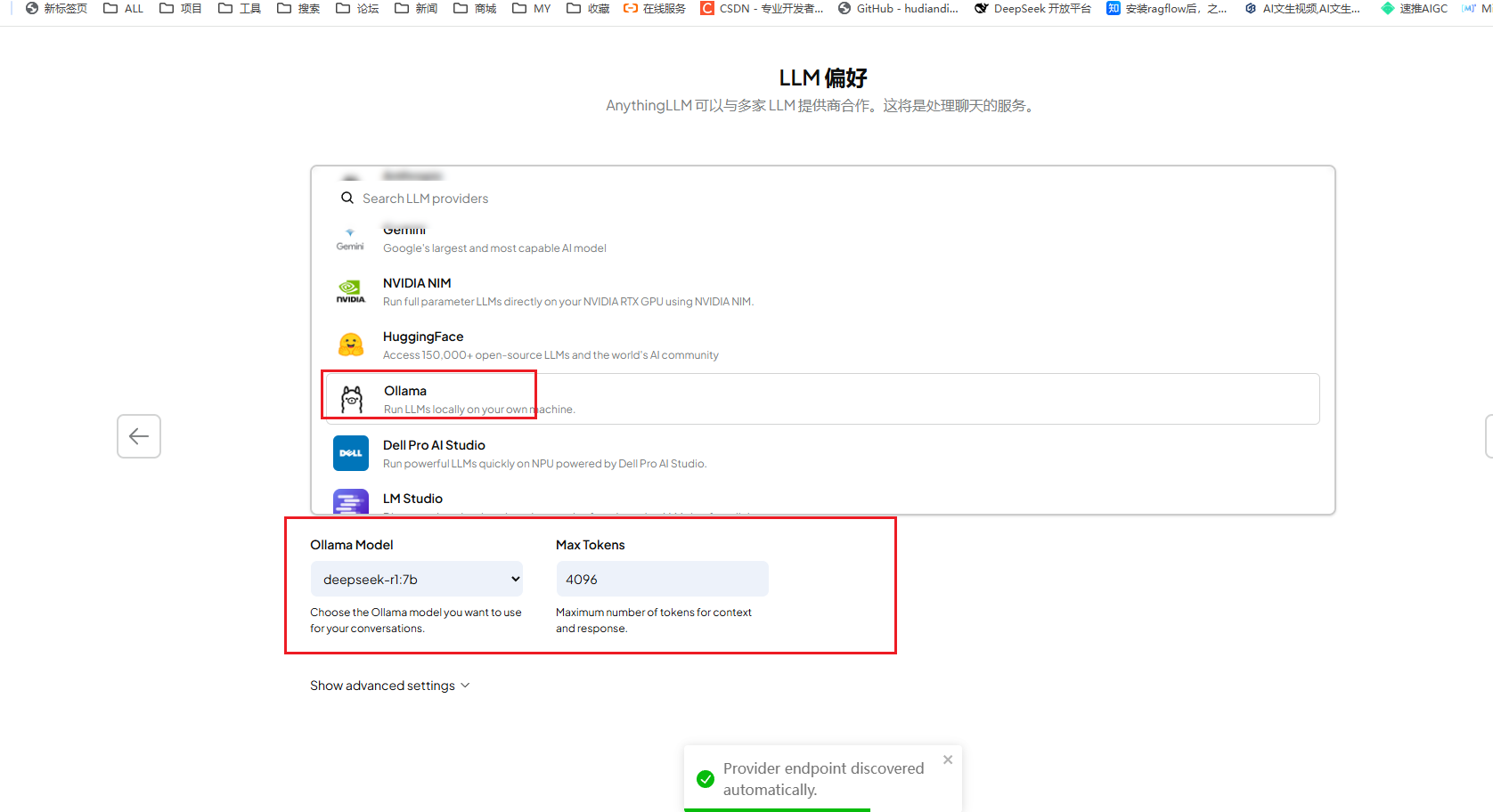

模型支持

- AnythingLLM:支持本地/云端模型混合部署,可对接主流大模型,包括本地私有大模型(如Llama 2)、OpenAI、Azure OpenAI和百度千帆大模型等。

- RAGFlow:依赖内置RAG流程,支持30多种开源模型,主要通过分层模块化架构,支持向量数据库的灵活替换与Embedding模型的自由选型。

Ragflow安装:https://blog.csdn.net/YXWik/article/details/149632904

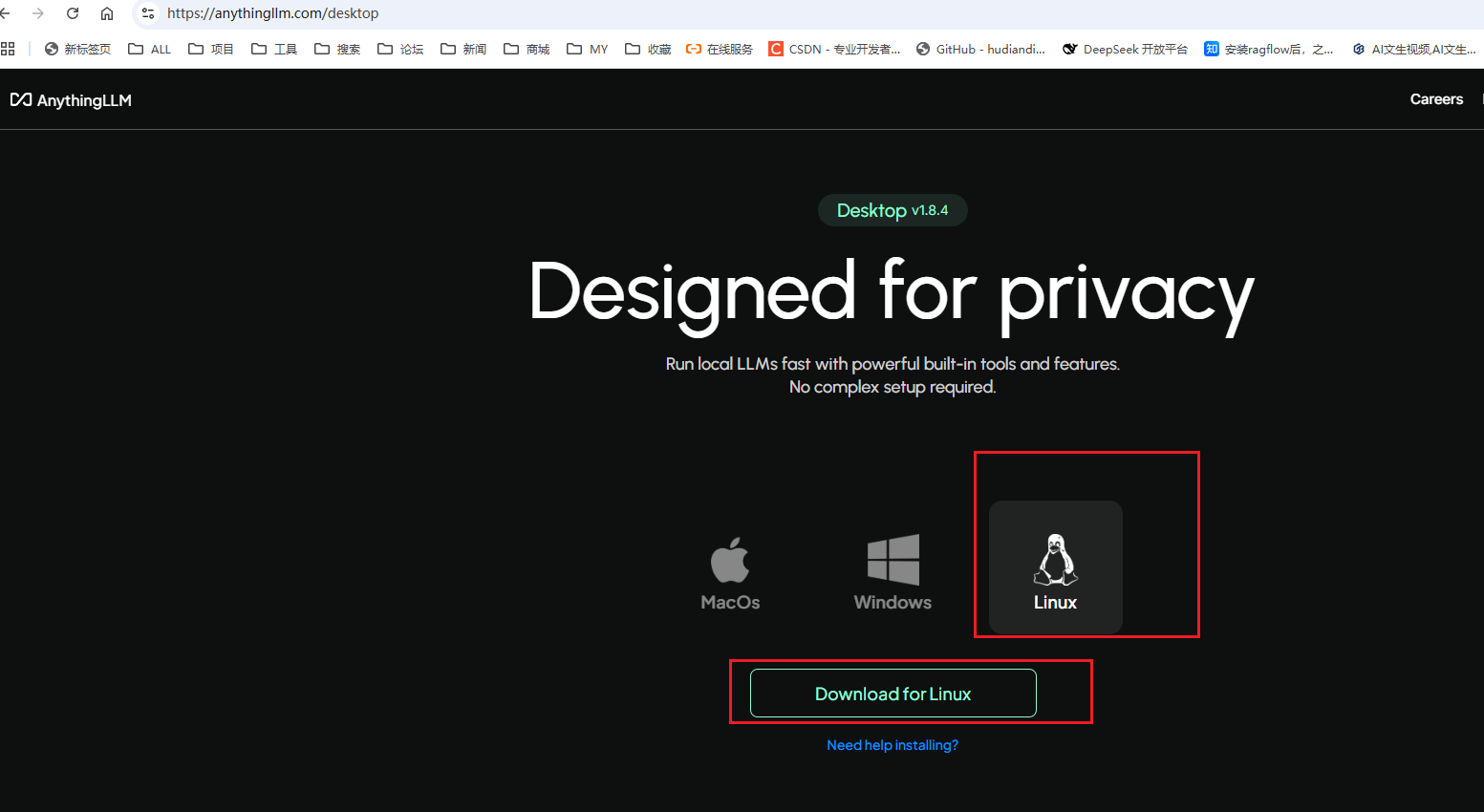

AnythingLLM地址:https://anythingllm.com/desktop

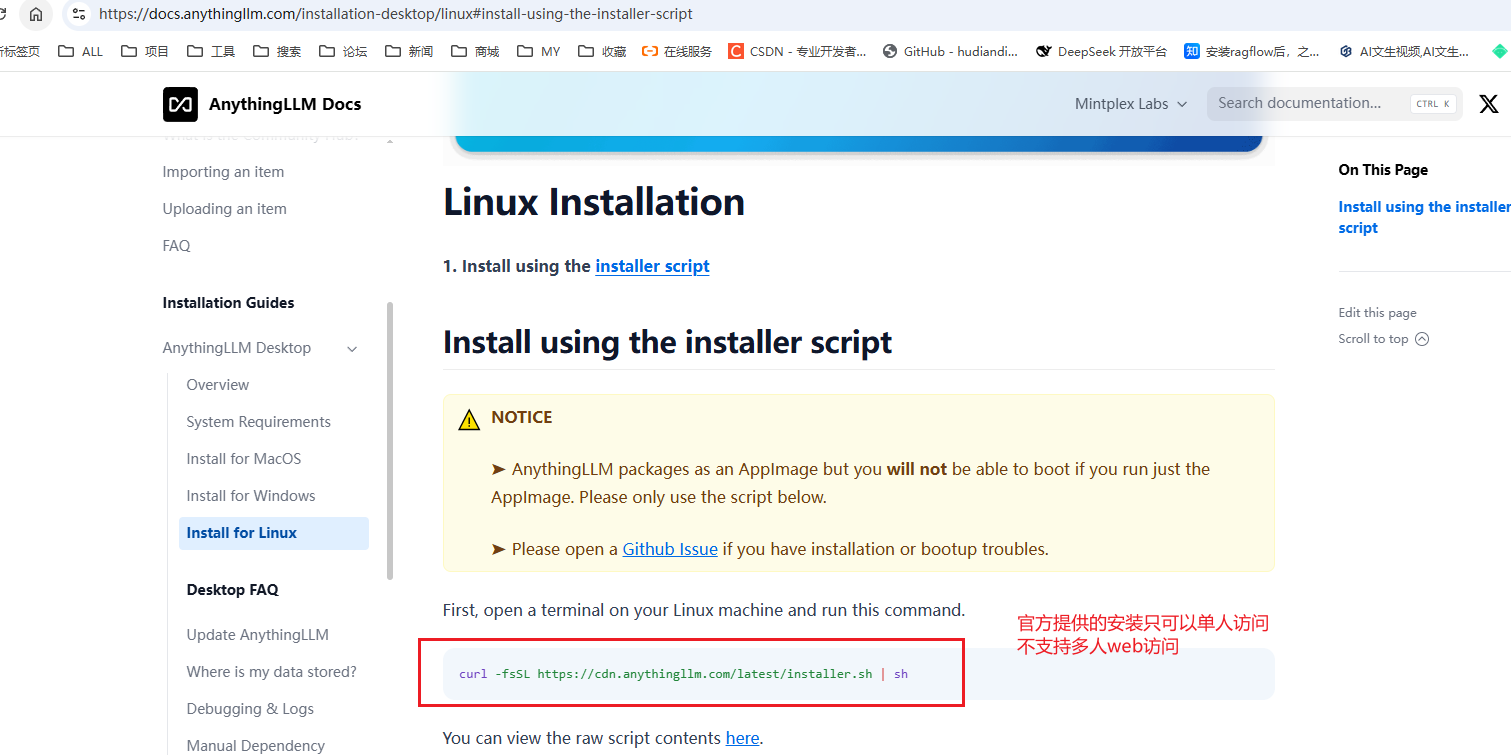

官网提供的Desktop脚本安装,只能够个人使用,无法多人使用

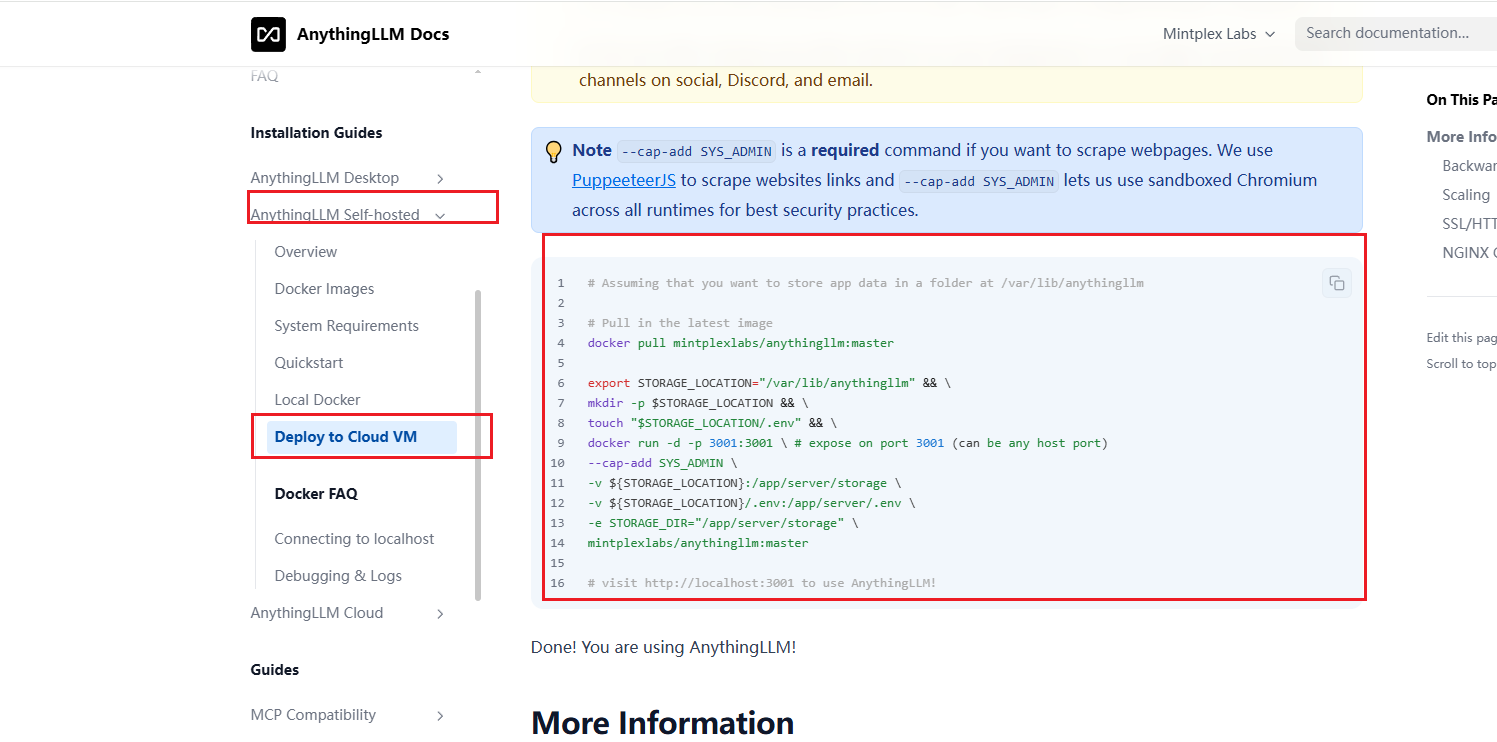

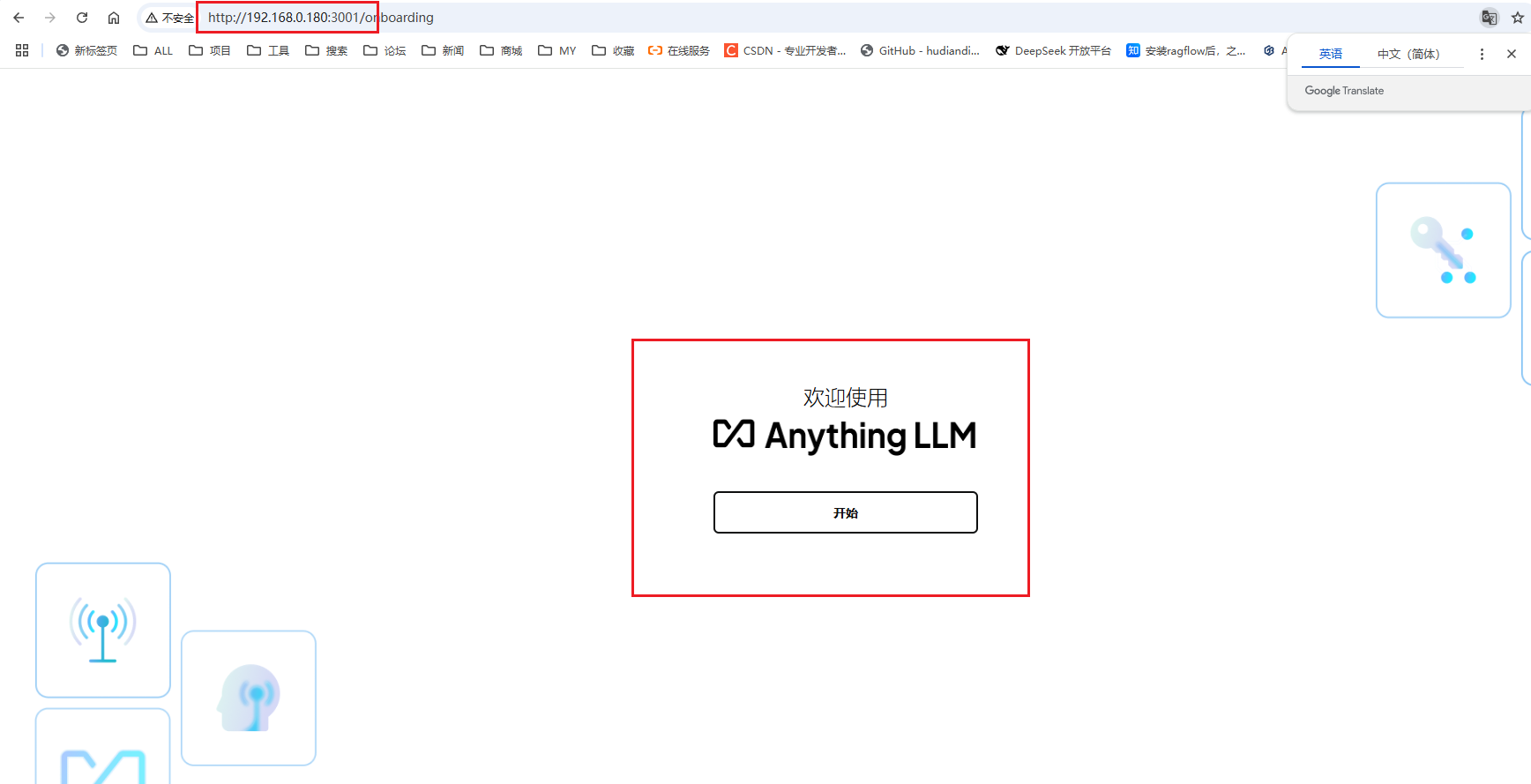

采用docker方式进行安装可以满足多人同时使用

Linux安装docker:https://blog.csdn.net/YXWik/article/details/128643662

如果需要安装docker+ollama的可以往下看下面有教程脚本地址

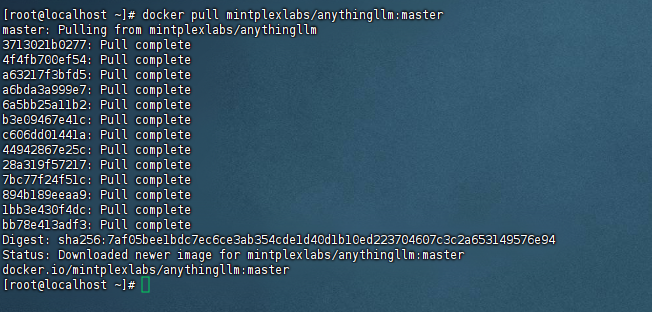

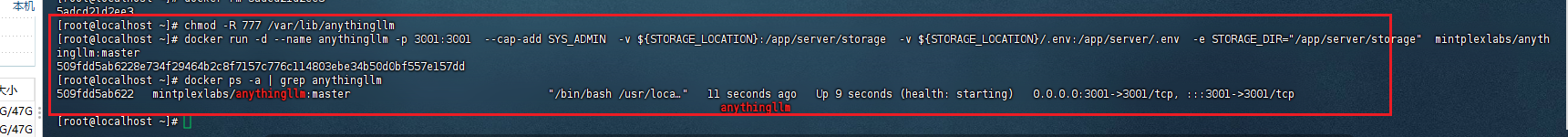

docker pull mintplexlabs/anythingllm:master

export STORAGE_LOCATION="/var/lib/anythingllm" && mkdir -p $STORAGE_LOCATION && touch "$STORAGE_LOCATION/.env" && chmod -R 777 /var/lib/anythingllm

docker run -d --name anythingllm -p 3001:3001 --cap-add SYS_ADMIN -v ${STORAGE_LOCATION}:/app/server/storage -v ${STORAGE_LOCATION}/.env:/app/server/.env -e STORAGE_DIR="/app/server/storage" mintplexlabs/anythingllm:master

如果访问不到 记得开放下端口:3001

我这里是 iptables

iptables -I INPUT -p tcp --dport 3001 -j ACCEPT

Linux安装docker+ollama+deepseek:https://blog.csdn.net/YXWik/article/details/149497501

Windows安装anythingllm :https://blog.csdn.net/YXWik/article/details/143883157

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)