ML+因果推断!2025顶会新风口爆发

【摘要】2025年顶会前沿研究聚焦机器学习与因果推断的融合创新,主要突破包括:1)CausalMM框架通过注意力因果分析缓解多模态大模型幻觉问题,性能提升达65.3%;2)FairPFN首创无需预设因果模型的公平性方案,在Adult等数据集展现优势;3)生成干预模型(GIM)在单细胞RNA药物扰动预测中实现机制解释与分布预测双优。这些研究通过因果表征学习、反事实推理等新技术,显著提升了模型可解释性

2025顶会新风口!机器学习+因果推断藏着大突破~

传统 ML易受数据偏见干扰,因果推断又面临建模复杂难题,而最新研究完美融合二者优势:创新因果表征学习、反事实推理框架,让模型既能精准预测,又能回答 “为什么”“如果怎样” 的问题。从金融风控到自动驾驶,该方向已成为顶会 “兵家必争之地”。想解锁前沿?这份论文合集千万别错过

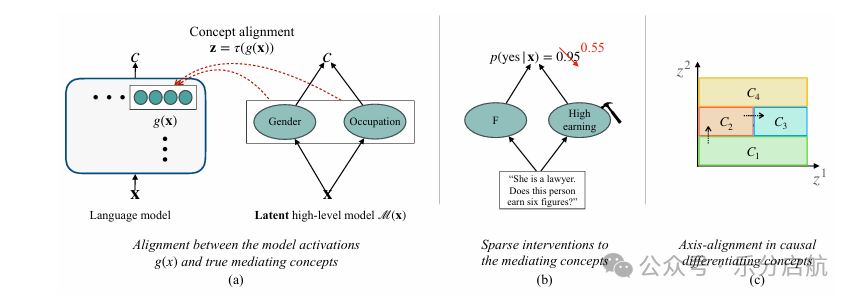

1. Causal Differentiating Concepts: Interpreting LM Behavior via Causal Representation Learning

【要点】本文提出了一种无监督算法,通过识别语言模型激活中的因果区分概念来解释模型行为,提高了模型的可解释性和鲁棒性。

【方法】作者使用了一种约束性对比学习目标,通过仅需对底层概念进行稀疏改变即可引发目标行为的原理,来发现可解释的潜在方向,即因果区分概念。

【实验】作者在合成和半合成环境中展示了该方法能够恢复地面真实因果因素,并在语言模型的拒绝行为案例研究中证明了方法的有效性,具体使用的数据集名称未提及。

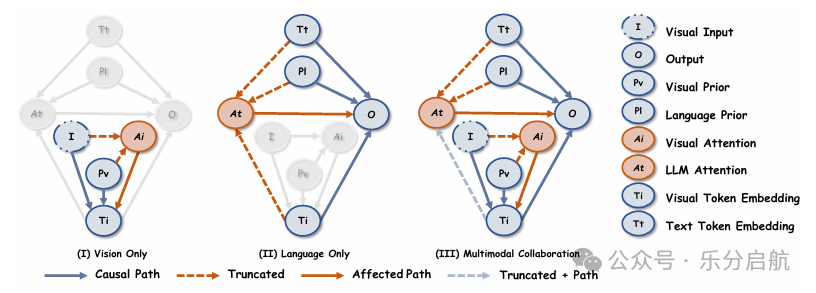

2. Mitigating Modality Prior-Induced Hallucinations in Multimodal Large Language Models via Deciphering Attention Causality (CausalMM)

【要点】本文提出了一种名为CausalMM的因果推断框架,通过在多模态大型语言模型中应用结构因果模型,有效缓解了模态先验引起的幻觉问题,提高了模型输入输出的对齐质量。

【方法】CausalMM采用背门调整和反事实推理方法,在视觉和语言注意力层面操作,以削弱模态先验对注意力机制的负面影响。

【实验】本文在多个基准数据集上进行了广泛实验,证明了所提方法的有效性,与传统方法相比,模型性能的最大提升达到了65.3 Benchmark。

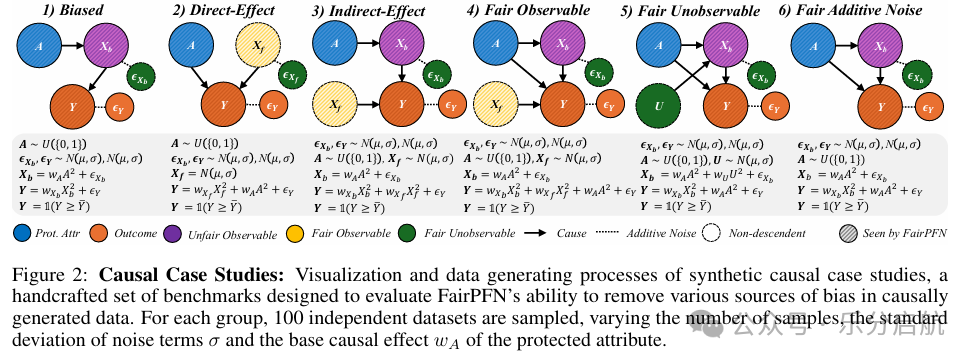

3. FairPFN: A Tabular Foundation Model for Causal Fairness

【要点】本文提出FairPFN,一种无需预设因果模型的表格基础模型,能够有效识别并缓解保护属性在预测中的因果影响,实现因果关系下的公平性。

【方法】FairPFN通过在合成的因果公平性数据上预训练,学习识别并消除预测中的保护因果效应,无需了解具体的因果模型。

【实验】研究者在多种手工制作和现实世界的场景中测试了FairPFN,使用的数据集包括Adult和Compas等,结果表明FairPFN相对于稳健基线方法在识别和去除保护因果效应方面表现更强。

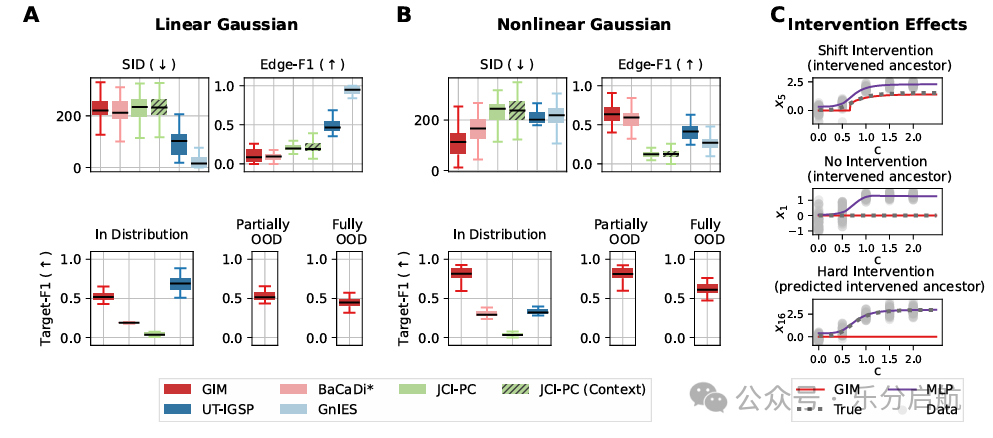

4. Generative Intervention Models for Causal Perturbation Modeling

【要点】本文提出了一种生成干预模型(GIM),通过映射扰动特征到原子干预的分布,在联合估计的因果模型中预测未见扰动特征的分布转移,并揭示其底层数据生成过程的机制效应。

【方法】通过学习将扰动特征映射到原子干预的分布,GIM在联合估计的因果模型中工作,从而在预测分布转移的同时,提供对扰动机制的洞察。

【实验】在合成数据和单细胞RNA测序(scRNA-seq)药物扰动数据上,GIM表现出了与无结构方法相当的对未见分布的稳健预测能力,同时在推断底层扰动机制方面通常优于其他因果推断方法。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)