Windows使用LM Studio部署DeepSeek R1模型

本地部署AI模型具有不受官方限制和保护隐私的优势,但性能较差且对硬件要求较高。推荐使用Windows10/11系统,配置至少8核CPU、16GB内存和8GB显存显卡。介绍了LMStudio等部署工具和常见模型如Qwen2-7B、DeepSeekR1等。详细说明了LMStudio的安装步骤、模型下载方法及配置要求。指出本地推理速度远慢于网页版,同时推荐了其他开源模型如secgpt-mini。适合开发

说明

本地部署的优势:

1、不受官方网站的内容相关限制

2、因为服务运行在本地,不用担心信息、文件内容泄露

以日常学习工作使用来说,使用现成的AI产品完全够用了。本地部署AI非常消耗资源,而且性能远远比不上官方的网站。

本文档主要用于体验模型部署。

注意,服务安装在云服务器有可能会导致未授权访问等漏洞。

推荐电脑配置

操作系统

Windows版本必须是Win10或者Win11。

最低配置

CPU:8核处理器(如AMD Ryzen 7或Intel i7)。

内存:16GB RAM。

显卡:至少8GB显存的显卡(如NVIDIA RTX 3060或AMD RX 6600)。

存储空间:至少50GB的硬盘空间。

推荐配置

CPU:8核或更高性能的处理器(如AMD Ryzen 7或Intel i7)。

内存:16GB RAM或更高。

显卡:12GB显存的显卡(如NVIDIA RTX 3060或AMD RX 6700)。

存储空间:至少100GB的NVMe SSD。

概要介绍

在本地部署AI系统,需要模型部署工具和模型文件(可以理解为规则集)。

模型部署工具主要包括:

- 如果你希望快速部署和管理本地模型,Ollama(命令行)和LM Studio(UI界面)是不错的选择。

- 如果你需要构建复杂的AI应用,AnythingLLM和Dify可能更适合。

- 如果你更注重客户端体验,Cherry Studio和OpenWebUI提供了丰富的功能和友好的界面。

常见的模型:

- Qwen2-7B-Math-Instruct(阿里巴巴)

- DeepSeek R1(深度求索)

- Kimi K1.5(月之暗面)

- GLM-Zero(智谱团队)

- DRT-o1(微信团队)

开源模型:

https://modelscope.cn/models

大模型命名的秘密:名称与后缀背后的意义

https://zhuanlan.zhihu.com/p/8246571643

安装LM Studio

这里我们以LM Studio为例进行安装。

LM Studio主要面向开发者、技术爱好者和研究人员,提供本地模型运行、模型微调、OpenAI兼容API服务器等功能。

它提供了一个用户友好的图形界面,让开发者和技术爱好者能够在本地运行、管理和微调各种LLM。

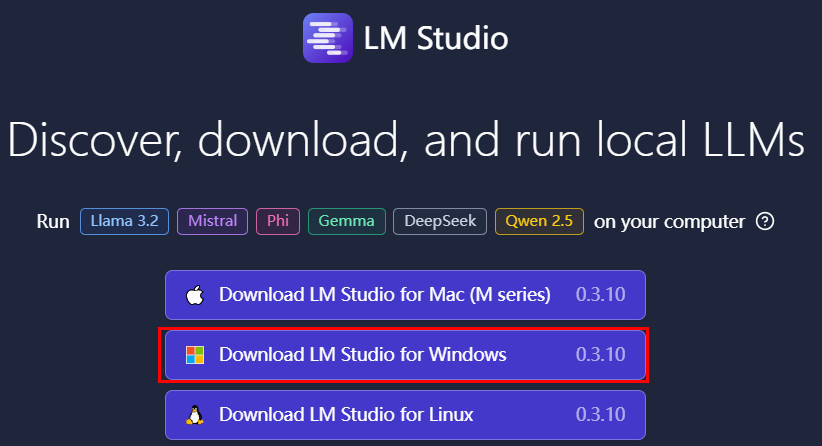

打开官网:https://lmstudio.ai/

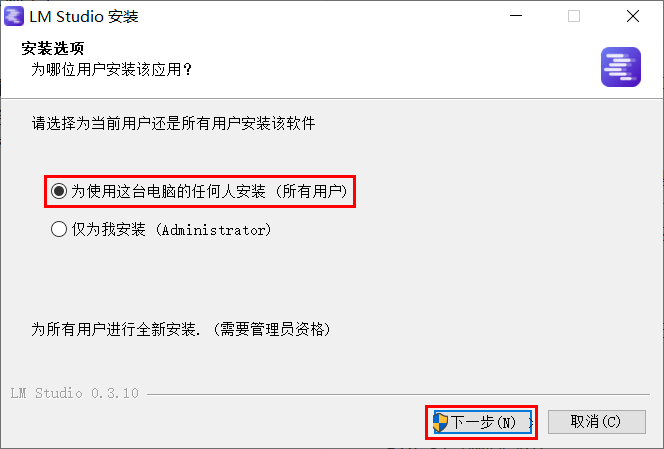

如果电脑只有一个用户,没区别。如果电脑有多个用户,根据情况选择。

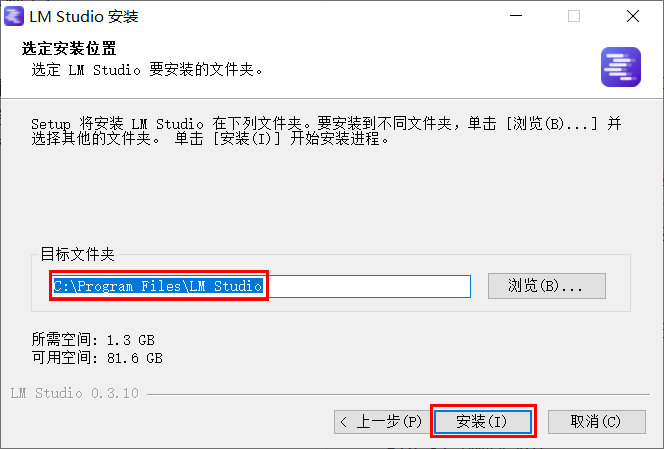

选择安装路径,工具可以安装在C盘,需要的空间不大。

模型可以放在其他磁盘。

启动LM Studio

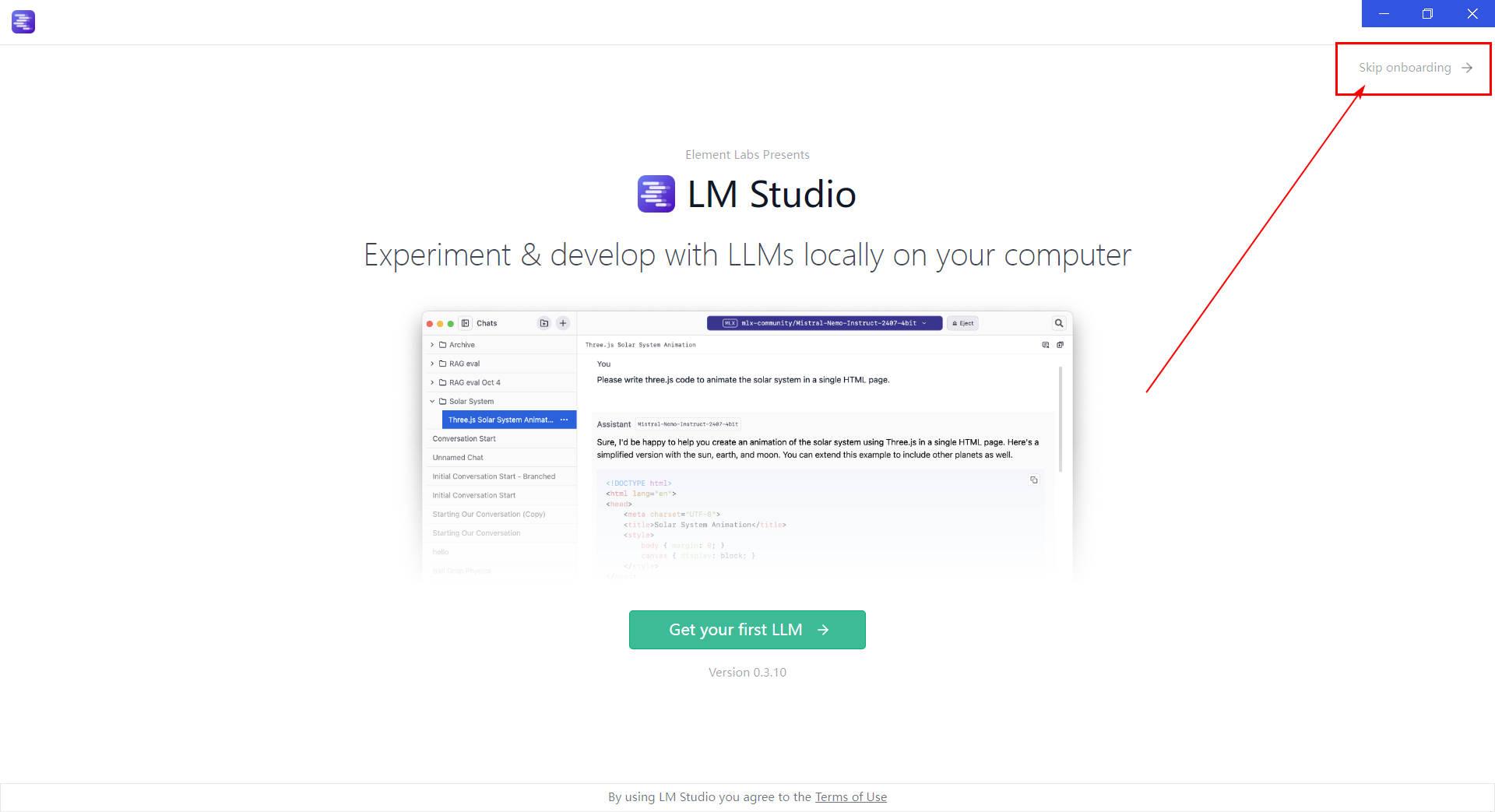

点完成,启动LM Studio

启动界面,跳过

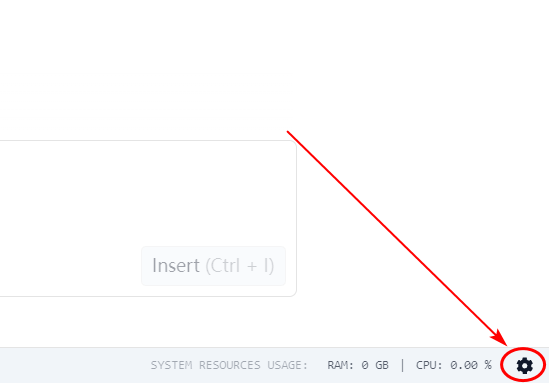

右下角齿轮设置图标

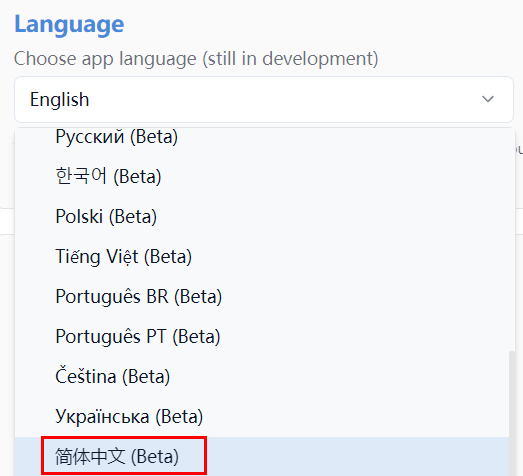

Language选择“简体中文”

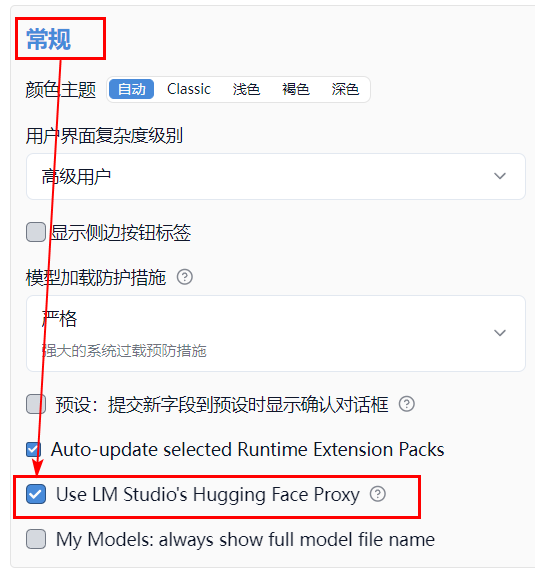

为避免网络问题,需要将默认的模型下载源更换为国内可访问的Hugging Face镜像

(也可以在网站离线下载:https://hf-mirror.com/ 、 https://www.modelscope.cn/models)

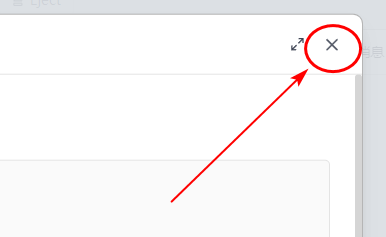

关闭设置窗口

下载模型

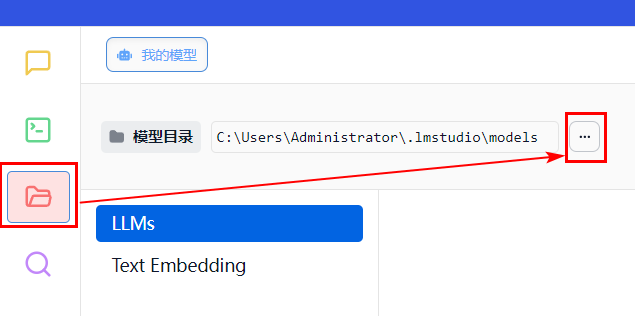

设置模型下载目录

修改模型目录,选择一个剩余空间更多的磁盘,可以创建一个models文件夹专门放模型

模型介绍

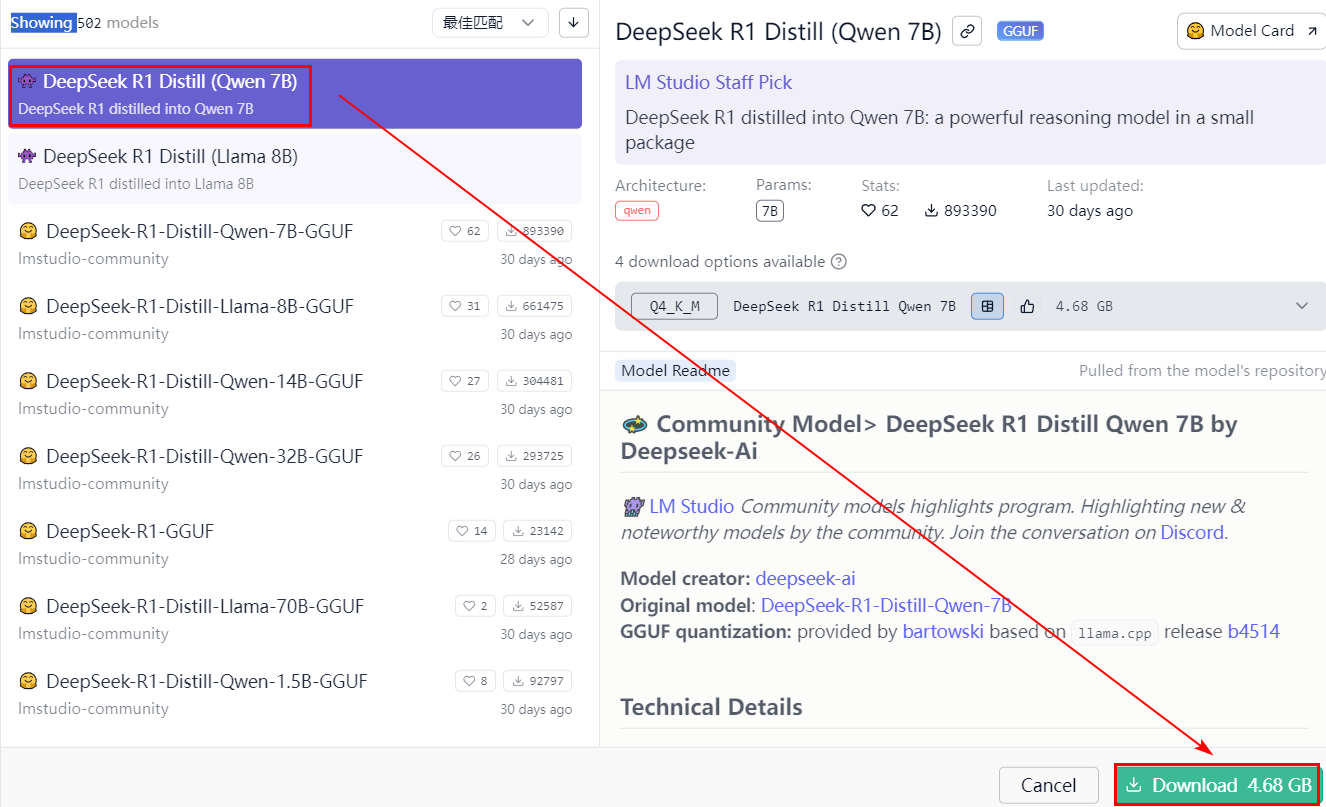

- DeepSeek-R1-Distill-Qwen-7B 是性价比最高的蒸馏版本,适合大多数生产场景,资源需求低且推理速度快。

- DeepSeek-R1-Distill-Qwen-32B 性能最强,适合对推理精度要求较高的场景。

如果对资源需求敏感,DeepSeek-R1-Distill-Qwen-1.5B 是一个不错的选择。 - 对于需要处理复杂任务的场景,DeepSeek-R1-Distill-Qwen-14B 或 DeepSeek-R1-Distill-Llama-70B 更为合适。

下载方式1

如果安装了Python,可以通过这种方式下载:

打开搜索到的模型页面:

https://modelscope.cn/models/lmstudio-community/DeepSeek-R1-Distill-Qwen-7B-GGUF/files

在下载前,请先通过如下命令安装ModelScopepip install modelscope

下载完整模型库到指定文件夹modelscope download --model lmstudio-community/DeepSeek-R1-Distill-Qwen-7B-GGUF --local_dir 'D:\models'

下载方式2

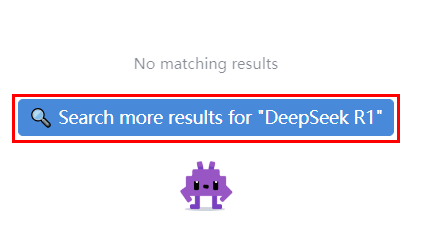

搜索模型DeepSeek R1

点 Search more

点击Download

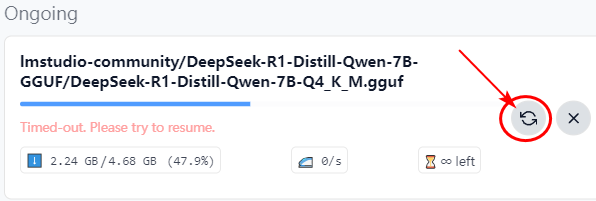

等待模型下载完毕。

如果网络出问题,点刷新的图标继续下载(有可能会中断多次,盯着点)。

附录:LMStudio下载了模型,但是找不到

https://wiki.bafangwy.com/doc/884/

加载模型

下载完成,加载模型:

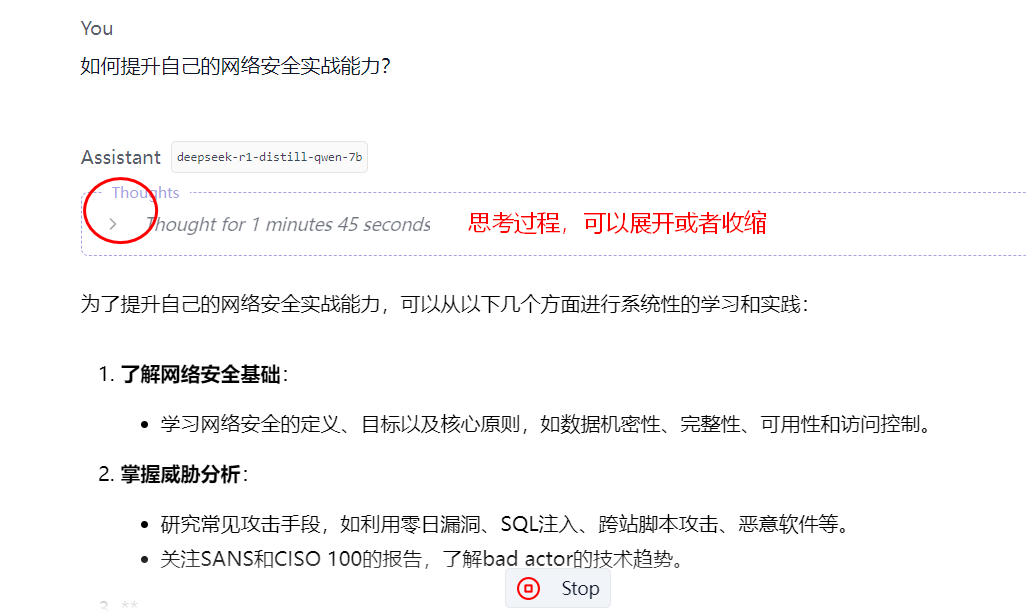

开始对话:

可以看到,思考过程花了100多秒,还没算后面的输出时间,效率比网页版低很多。

其他推荐开源模型

搜索 secgpt(网络安全开源大模型),下载secgpt-mini

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)